Ou plutôt,

les solutions pour gérer les documents tels que nous les connaissons vont disparaître à moyen terme. Les éditeurs vont devoir évoluer, se faire acheter, ou s’éteindre. Quant aux archivistes ou aux informaticiens concernés, c’est certain, leurs fonctions vont évoluer ou disparaître.

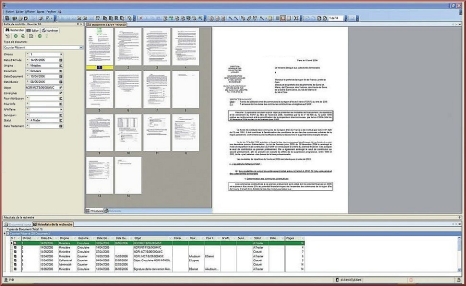

L’objectif principal et initial de la GED était de permettre la gestion de vos documents au travers d’un plan de classification et d’un calendrier de conservation, et bien entendu de retrouver vos ‘affaires’ dans la masse de ce que l’on appelait les archives.

Nous avons connu historiquement des solutions majeures et massives apparues dans les années 90, s’appuyant sur des bases de données SQL.

Le marché s’est développé progressivement au travers d’importants chantiers en clientèle, pour les gros joueurs comme Filenet (racheté par IBM en 2006), OpenText, Stellent (racheté par Oracle en 2006) ou encore Documentum racheté en 2003 par EMC puis par Dell en 2016 qui l’a revendu à son tour, la même année, à OpenText.

Pendant ce temps, des solutions mineures ont su offrir aux marchés des organisations de moyenne taille, des fonctions plus accessibles, aux options plus nombreuses, plus proches des utilisateurs, plus faciles à mettre en œuvre et moins coûteuses.

Puis, par la suite, la plateforme Sharepoint de Microsoft est arrivée pour tenter de rattraper ce marché avec une offre originale est très ouverte, suivie par des solutions open source (ouvertes par définition), comme Alfresco leader dans ce mouvement. Ces solutions ont, aussi été proposées aux petites et moyennes organisations. Finalement, le résultat est comparable aux grosses solutions. : Des projets souvent sans fin, aux coûts hors de proportions par rapport aux attentes de la clientèle.

Les solutions majeures

Ces solutions ont été conçues en premier lieu pour répondre à ce que nous appelions, à l’époque, de gros volumes en s’appuyant sur les bases de données SQL. L’ergonomie n’était pas vraiment une préoccupation prioritaire pourvu qu’il soit possible de conserver en sécurité et de rechercher ses documents.

Ces solutions ont, la plupart du temps, offert le service attendu à certains niveaux, mais dans les projets d’envergure, la réalité a souvent été décevante. En effet, les dérives au niveau de l’adaptation aux règles d’affaires, et des contraintes d’intégration puis d’infrastructures, aggravées par une croissance majeure des volumes à traiter, ont mené à l’essoufflement de nombre de projets, voire à des impasses. Souvent, avec des solutions finalement amaigries au niveau des fonctionnalités, les utilisateurs se contentent ultimement de rechercher leurs documents au travers de l’explorateur de leur ordinateur…Quant aux solutions ouvertes comme Sharepoint ou Alfresco citées plus haut, elles se révèlent justement trop ouvertes et deviennent finalement assez complexes.

C’est ainsi que les développements puis la maintenance peuvent prendre des proportions annihilant les bénéfices attendus, et confinent, ces solutions, aux mêmes résultats que les ‘Gros’ cités plus haut.

Les solutions mineures

Pendant ce temps se déployaient des solutions plus modestes développées à partir de DBase qui a connu ses heures de gloire lorsque Borland en était le propriétaire, ou Access de Microsoft ou encore FileMaker d’Apple. Ceux que l’on appelait les ‘petits’ éditeurs, se sont attachés à l’ergonomie au niveau de l’interface utilisateur, et surtout à livrer une solution prête à l’emploi. Ils ont pris leur essor dans le contexte de la mise en service de la numérisation ou dans les projets d’archivage documentaire, pour des entreprises de taille moyenne ou certains services départementaux au sein de plus grosses organisations.

Les produits comme Scanfile, Laserfiche ou M-Files ont longtemps été cités comme ‘petits’. Si le marché ne leur a pas forcément donné la chance de démontrer leur capacité à gérer des volumes importants, ils ont eu l’avantage d’offrir des solutions achevées pour lesquelles les modifications et autres adaptations aux spécificités de chaque organisation se faisaient par simple paramétrage plutôt que par développement informatique. Ah!!!!! Si ces solutions avaient pu répondre à des cahiers des charges ambitieux réservés aux ‘grands’, ou apporter la versatilité et la simplicité de paramétrage plutôt que le codage des interfaces….

Offres complémentaires

Nombre d’éditeurs ont développé des fonctions complémentaires comme la numérisation, ou la gestion des courriels, ou encore des processus documentaires, comme des modules plus ou moins intégrés.

Parallèlement, ce sont d’autres éditeurs qui se sont consacrés à offrir, de manière autonome, en complément des solutions de GED, des solutions de capture de données et la saisie automatisée de documents d’affaires comme les factures. On peut citer Kofax, ou Captiva, eux aussi rachetés depuis.

Certains acteurs offrent une approche de type ‘’tout inclus’’ avec des fonctionnalités additionnelles, issues, la plupart du temps, non pas de développements, mais de rachats de compagnies tierces, comme, par exemple, la gestion des processus, la gestion de la connaissance, et la BI pour l’intelligence d’affaires.  C’est souvent une approche d’abord marketing. Cela ne permet de pas d’améliorer la performance de la solution d’origine, mais permet de séduire la clientèle, alors qu’il devient impossible d’empêcher la dégradation de la performance de la solution en place, due, principalement, à la noyade des documents dans des volumes devenus gigantesques, dans le contexte d’un besoin d’intégration plus large et plus profonde au sein des systèmes des organisations.

C’est souvent une approche d’abord marketing. Cela ne permet de pas d’améliorer la performance de la solution d’origine, mais permet de séduire la clientèle, alors qu’il devient impossible d’empêcher la dégradation de la performance de la solution en place, due, principalement, à la noyade des documents dans des volumes devenus gigantesques, dans le contexte d’un besoin d’intégration plus large et plus profonde au sein des systèmes des organisations.

Enfin, nous assistons à un début de concentration avec le rachat de Documentum par OpenText, ce qui en fait le plus gros joueur de la planète. Nous observerons bientôt le devenir des deux plateformes regroupées sous un même toit.

Mais il est maintenant trop tard pour considérer la GED comme une solution d’avenir!

La GED est en retard sur son agenda. Elle n’a globalement pas su livrer ce dont les organisations avaient besoin. Elle est surtout confrontée, désormais, à des contraintes importantes comme la performance des infrastructures et surtout de nouveaux enjeux légaux qui impliquent de ne plus gérer les seuls documents, mais aussi les données contenues dans ceux-ci et même les données détenues indépendamment par les bases de données.

En effet, la législation avance quant à la protection des renseignements personnels et l’accès à l’information.

Alors:

- Savez-vous ce que contient chacun des documents en votre possession?

- Est-ce que la totalité des documents a été traitée de manière à en permettre la recherche plein texte?

- Gérez-vous avec votre GED et ses règles, les documents en cours de collaboration au sein des processus d’affaires?

- Savez-vous localiser les documents en double et les versions différentes de tout document au sein de votre système d’information?

- Savez-vous localiser un unique document final signé et archivé?

- Savez-vous gérer vos données et vos bases de données de manière à respecter les délais de conservation applicables comme ils le sont pour les documents

- Êtes-vous satisfaits de votre solution actuelle?

Ma vision personnelle est la suivante :

La solution capable de répondre à ces enjeux anciens devenus gigantesques au niveau des volumes, et nouveaux pour lesquels ni les solutions ni des déploiements judicieux réalisés ne permettent de répondre, réside dans un virage majeur au niveau de l’architecture. Celui va d’une part scinder les activités pour les traitements et d’autre part, gérer la totalité des documents et des données en gouvernance au niveau de l’entreprise.

Les technologies sont là!

Il manque encore la connaissance sur le marché de ces solutions, de ces technologies innovantes, et la volonté de provoquer ce virage. Mais, attention, nous ne sommes pas loin du moment où plus rien ne sera possible pour traiter de manière uniforme l’ensemble des documents, et de garantir la conformité légale.

Par exemple, 2018 est l’année de la mise en application de nouvelles lois en Europe.

- MiFID II, est une norme qui apporte des changements profonds sur la transparence des marchés financiers et défense des investisseurs

- Le Règlement général sur la protection des données(RGPD) (le règlement s’appliquera aux entreprises établies en dehors de l’Union européenne…)

Comment faire?

- Nous sommes forcés de reconnaître que la GED traditionnelle ou telle que nous la connaissons encore aujourd’hui se résume ultimement à un plan de classification et un calendrier de conservation. Les métadonnées sont souvent surtout utilisées pour assumer ces fonctions. Cette vue ancienne et qui malheureusement perdure est très limitative et n’apporte finalement que très peu de valeur ajoutée aux organisations. Souvent, nous ne nous intéressons pas et ne prenons pas en compte l’information qui se trouve au sein des documents. Or le contenu et les métadonnées des documents constituent une mine d’informations ne demandant qu’à être exploitées, aujourd’hui ou plus tard.

- Savoir exploiter au mieux l’information se trouvant dans les documents procurera un avantage stratégique et compétitif supplémentaire. Ce serait dommage de vouloir considérer la seule l’information associée aux documents sans prendre également en compte l’information référentielle se trouvant dans les différents systèmes d’information présents dans l’entreprise. Plus largement, il peut être très important, en complément d’un traitement complet de l’information, que celle-ci soit de nature structurée ou non structurée, d’exploiter l’information résidant à l’extérieur de l’entreprise.

- Les solutions de GED actuelles n’apportent pas de réponses efficaces à ces problématiques. De la même manière, les solutions basées sur des bases de données relationnelles sont incapables de traiter de manière performante l’information de nature non structurée.

- Afin de répondre à ces enjeux, nous devons nous tourner vers des solutions innovantes permettant de collecter, contrôler, corréler et effectuer de l’analyse prédictive et descriptive de très grands volumes de données hétérogènes de nature structurée ou non structurée. Cette approche permet de combiner le meilleur des solutions de GED et des solutions basées sur les bases de données relationnelles mais en s’affranchissant de leurs contraintes et limitations.

Cette révolution dans l’architecture se légitimera par l’utilisation mutuelle des données et des traitements. Par exemple, si un processus d’affaires utilise et met à jour une information celle-ci sera disponible avec sa mise jour pour le reste des systèmes de l’organisation. Ainsi les investissements de chacun profiteront à tous.

À l’arrivée de l’Intelligence d’affaires nommée BI, et des ERP, la fusion de l’information a été rendue possible grâce aux ETL. La mutualisation, de son côté, l’a été grâce aux EAI devenus aujourd’hui plus évolués sous le terme ESB .

Aujourd’hui Big Data et croissance des demandes requérant de l’intelligence artificielle, pour des processus de plus en plus automatisés, voire robotisés, provoquent une croissance de la manipulation des données dans des proportions gigantesques.

et croissance des demandes requérant de l’intelligence artificielle, pour des processus de plus en plus automatisés, voire robotisés, provoquent une croissance de la manipulation des données dans des proportions gigantesques.

Si nous devions lister les principales caractéristiques de la solution idéale, elles seraient les suivantes :

- Gérer et stocker de très grands volumes de données structurées et non structurées (documents, fichiers multimédias, courriels, etc.).

- Offrir les fonctionnalités classiques attendues par une GED (consultation, contribution, gestion des versions, gestion des politiques de rétention, recherche plein-texte, etc.)

- Savoir exploiter les métadonnées comme des données

- Intégrer aisément toute source de données existante et future (GED, progiciels de gestion intégrés, bases de données relationnelles, ressources disponibles sur Internet, etc…)

- Permettre une intégration non perturbatrice avec les systèmes informatiques existants.

- Assumer la cohabitation ou la migration de plusieurs solutions de GED au sein d’une même organisation

- Pouvoir enrichir dynamiquement les documents d’informations pertinentes

- Automatiser la classification et le marquage des documents

- Corréler aisément les données non structurées et structurées, de différents systèmes

- Proposer un moteur puissant d’indexation et de recherche

- Offrir la fonction de bi-temporalité. (La bi-temporalité permet de disposer d’un tableau précis des données, à tout moment. Cette fonction s’avère particulièrement utile au sein des secteurs réglementés. La bi-temporalité permet d’obtenir de meilleures réponses aux problématiques posées par les données d’aujourd’hui, d’hier et de demain.)

- Assurer un haut niveau de sécurité afin d’assurer la protection et la confidentialité des données.

- Chiffrement des données

- Non-exposition de certaines données sensibles ou remplacement par d’autres valeurs pour éviter les fuites de données. (accès restreints ou caviardage)

- Sécurité au niveau des éléments spécifiques ou des métadonnées des documents pour apporter un niveau de sécurité encore plus granulaire qu’une sécurité réalisée au niveau du document.

Conclusion :

La GED va persister en tant que règles dans l’architecture évoquée ici dans cette vision. Celle-ci sera composée, par exemple, de moyens de type ETL moderne ultra performant et d’ESB, s’appuyant sur des bases de données de type NoSQL. Des moteurs de type sémantique statistique et même prédictif seront utilisés pour créer avec les données ce qui s’appelle de l’Intelligence Artificielle. La gouvernance ou l’interopérabilité de l’information sera implicite et sécuritaire.

La GED va persister en tant que règles dans l’architecture évoquée ici dans cette vision. Celle-ci sera composée, par exemple, de moyens de type ETL moderne ultra performant et d’ESB, s’appuyant sur des bases de données de type NoSQL. Des moteurs de type sémantique statistique et même prédictif seront utilisés pour créer avec les données ce qui s’appelle de l’Intelligence Artificielle. La gouvernance ou l’interopérabilité de l’information sera implicite et sécuritaire.

La classification des documents, et désormais des données, sera représentée dynamiquement aux utilisateurs, en fonction des règles de classification d’une part et des règles d’affaires et de sécurité de l’autre. Le calendrier de conservation des documents comme des données sera appliqué au travers de règles, pour être déclenché de manière événementielle.

Cette approche que je juge et souhaite disruptive est comparable, par exemple, à l’avènement des serveurs en réseaux au début des années 90 en remplacement des Mainframes ou Gros systèmes, seuls capables de faire les traitements demandés jusqu’à cette époque. Cette génération, encore présente, apportait un grand progrès en étant plus performants, moins cher, et plus souple à déployer et à maintenir.

Pensez-y et gardez ce document en mémoire; nous en reparlerons probablement bientôt.

Philippe Goupil

« Savoir exploiter au mieux l’information se trouvant dans les documents procurera un avantage stratégique et compétitif supplémentaire. »

Non seulement, le GED est « overrated » mais en plus, il faut maintenant avoir des solutions qui gèrent, analysent et rendent utile les données structurées et non structurées! Les années à venir vont être très intéressantes 🙂 Merci pour cette article.

J’aimeJ’aime

Merci pour votre commentaire ! Les commentaires sur Linkedin vont majoritairement dans le même sens.

J’aimeJ’aime

Super article… Nous avons déjà des solutions qui répondent en grande partie à ce que vous mentionnez. Nous sommes également à intégrer le « Machine Learning » afin de, tranquillement, pouvoir offrir une certaine intelligence artificielle à la gestion de l’information.

J’aimeJ’aime

Voilà un article très intéressant et qui illustre bien les problématiques rencontrées et l’horizon vers lequel il nous faut tendre. La GED n’est pas une fin en soit : il nous faut penser « global » et exploitation pérenne de la connaissance de l’entreprise, toutes sources confondues.

J’aimeJ’aime

Merci pour votre article, très intéressant! Pardon, mais je n’avait pas compris cette phrase: « Cette génération encore présente permettait un grand en étant moins chers, »

J’aimeJ’aime

Merci pour votre remarque. La correction a été faite. Cordialement

J’aimeJ’aime

Je vous remercie pour l’attention

J’aimeJ’aime

Archimag parle de cet article ARCHIMAG page 24

J’aimeJ’aime

Ping : SAP pourrait racheter opentext ! | Entreprise numérique